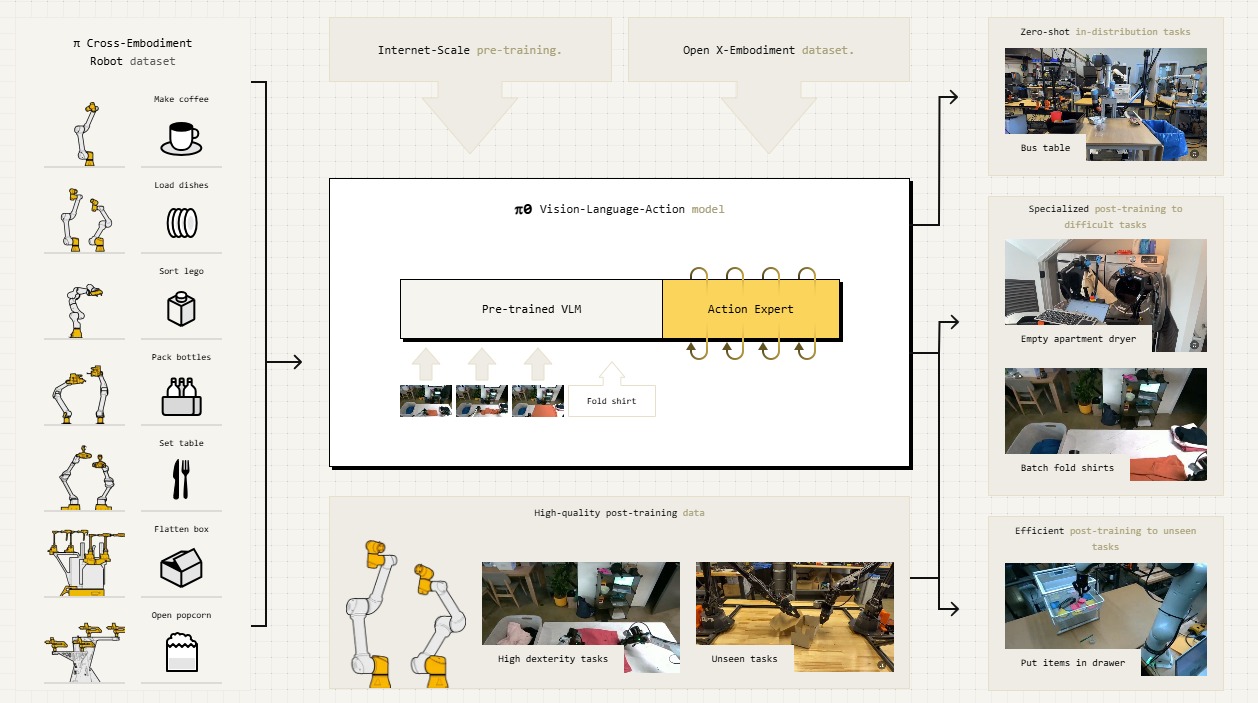

파이제로 오픈소스 / 사진. 피지컬 인텔리전스

사용자의 자연어 명령을 로봇의 물리적 동작으로 직접 변환하는 범용 로봇 파운데이션 모델이 등장했다. 인공지능(AI) 연구기업 허깅페이스와 피지컬 인텔리전스가 2025년 2월 6일(목) 비전-언어-행동(VLA) 모델 ‘Pi0(이하 파이제로)’를 오픈소스로 공개하며, 로봇 제어의 새로운 가능성을 열었다.

파이제로는 기존의 대형언어모델(이하 LLM)처럼 텍스트 기반 응답을 생성하는 것이 아니라, 사용자의 자연어 명령을 해석해 로봇이 즉시 수행할 수 있는 물리적 행동으로 변환하는 모델이다. 기존의 로봇 시스템이 특정 작업을 수행하려면 사전에 정교한 코드가 필요했지만, 파이제로는 이를 필요로 하지 않는다. 사용자는 챗봇과 대화하듯 로봇에게 작업을 요청할 수 있으며, 모델은 해당 명령을 실시간으로 분석하고 모터 명령을 생성해 로봇이 즉각 반응하도록 한다.

이 모델은 웹상의 텍스트 및 이미지 데이터와 함께 다양한 로봇 데이터를 학습한 비전-언어 모델(VLM)을 기반으로 한다. 특히 초당 최대 50회의 모터 명령을 생성할 수 있도록 훈련되어 있어, 보다 자연스럽고 정밀한 움직임이 가능하다. 이를 위해 확산 모델의 변형인 '흐름 매칭(Flow Matching)' 기술을 적용해, 로봇이 연속적인 동작을 수행하도록 설계됐다.

파이제로는 단순한 이동 명령뿐만 아니라, 세탁물 접기와 같은 복잡한 작업도 수행할 수 있다. 이를 위해 사전 학습된 모델을 로봇 데이터로 미세 조정하는 과정이 적용된다. 이는 LLM의 사후 학습(post-training) 방식과 유사하며, 사전 학습을 통해 로봇이 물리적 세계를 이해하고, 미세 조정을 통해 특정 작업을 보다 정확하게 수행할 수 있도록 한다.

성능 평가에서도 파이제로는 강력한 결과를 보였다. ‘오픈VLA(OpenVLA)’나 ‘옥토(Octo)’와 같은 기존 VLA 모델들과 비교했을 때, 30억 매개변수를 가진 파이제로는 모든 작업에서 가장 높은 성능을 기록했다. 9억 3천만 매개변수로 구성된 '파이제로-스몰(Pi0-Small)'도 두 번째로 높은 성과를 보이며, 다양한 크기와 용도로 활용될 수 있음을 입증했다.

이번 모델 공개는 로봇 업계에서도 큰 반향을 일으켰다. 허깅페이스 레민 케이든 수석 연구원은 "많은 개발자들이 코드와 가중치를 요청해 파이제로와 사전 훈련된 체크포인트를 공개하게 됐다"라며, "공개된 로봇에서 직접 모델을 테스트할 수 있으며, 연구자들이 원하는 방식으로 미세 조정할 수 있도록 코드를 포함했다"라고 밝혔다.